尊敬的各位读者,今日我们将深入探讨大数据领域中的关键技术——Hive在社交媒体聊天内容信息处理上的实际应用。如若您对此方面有所热衷,热烈欢迎跟随此文了解更多详细内容。在此文中我们将重点解析Hive如何改善社交平台数据品质,使数字信息拥有更高的实用性与商业价值。

Hive的基本操作回顾

在此之前,让我们简短地回顾一下Hive的操作方法。作为基于Hadoop强大基础上建立的数据仓库工具,Hive能以类似SQL的方式访问和分析庞大数据集合。前期所学已为我们奠定了扎实的Hive入门基础,现在正是实践应用的决胜时刻!

社交平台数据的重要性

各大社交媒体平台内,每日互动聊天中储存了巨量宝贵信息。这些数据不仅有文本表面,更深层次的挖掘能展现巨大的价值,如同金矿一般丰富。精准的数据统计与深入研究,帮助我们精准勾勒出用户肖像并定制相应的个性化服务,助力运营效率提升,同时也提升投资收益。这种行为不仅符合数据处理规范,也是对未来趋势的洞察力体现。

数据清洗的必要性

然而,此类数据非直观可用。如同矿石须精炼提纯方得贵重金属,我们也必须对聊天记录进行整理分类,以保证信息质量。数据处理的关键在于去伪存真,消除无用信息保留有价值的部分。

Hive在数据清洗中的应用

在进行数据清洗过程时,Hive的价值主要体现在两个阶段。第一个阶段即为数据引入Hive系统中,这一步骤如同在矿山建立基础的初阶加工厂。接着,可能会遇到诸如数据字段出现空白值或者是时间字段处理等挑战。这个关键之处便在于展示Hive强大的功能性。

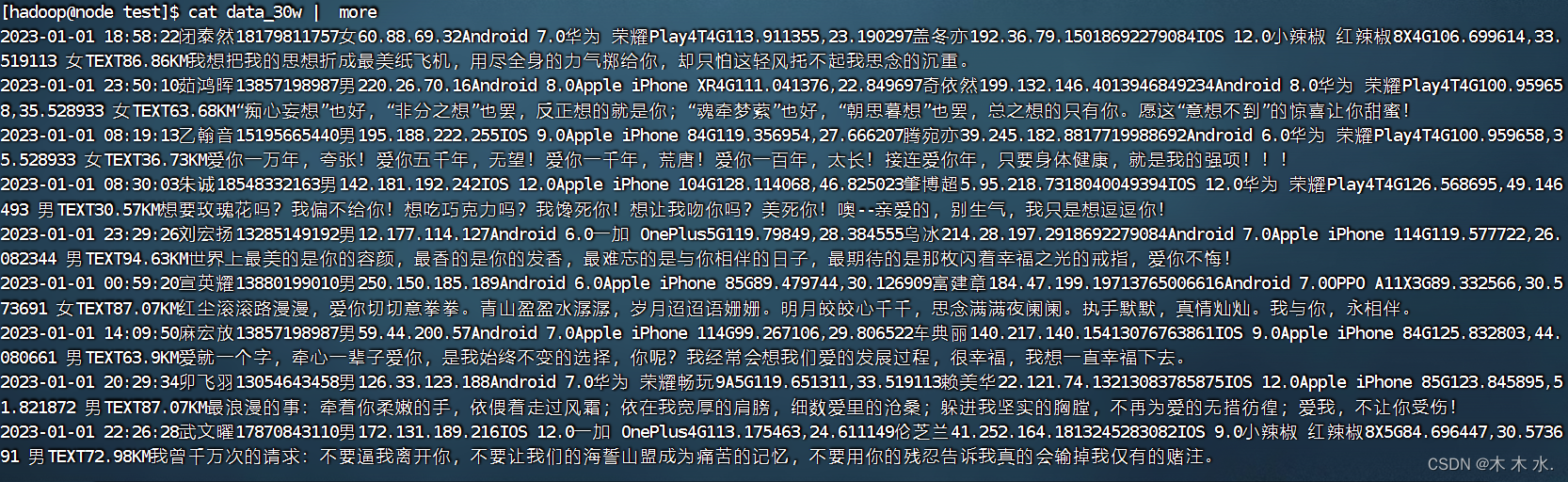

##先查看数据的大致样式

cat data_30w | more

创建ETL表

在数据清洗工作中,我们需要构建ETL表格,这是关键性的三步流程——抽取、转换和加载。通过提取原始数据中的有价值部分并加以适当调整修正后,再将结果载入新表以实现应用目的。此过程虽然复杂,但凭借Hive的强大工具便能轻松完成。

ETL过程的详细步骤

##创建HDFS目录下的/chat/demo

hdfs dfs -mkdir -p /chatdemo/data

##将本地数据上传上去

hdfs dfs -put data_30w /chatdemo/data

以理解ELT流程为基础,熟识其中关键步骤。首要任务便是从原始数据库中提取有价值的信息,犹如从矿物质中获取黄金。接下来是对数据进行处理和转化,譬如填补缺失数据,解析时间格式等等。最终阶段,将处理完毕的数据载入新的表格,至此完成整套ETL流程。

数据清洗后的价值

经过全面彻底的数据清洗后,所得数据质量显著提升,更具有重要应用价值。这将协助我们进行精准分析,深度解读用户行为习惯,进一步优化产品功能并持续提高用户满意度。整个过程不仅是单纯的数据处理,更体现出对信息价值的深度挖掘与运用。

总结与展望

本篇解析至此告罄。借助Hive与复杂算法的结合应用,我们更加深入地理解和熟练掌握了精确捕捉社交媒体对话内容之术,揭示出数据清洗的价值及其深远意义。希望通过此文,能激发您对大数据的热爱与追求。让我们共同努力,在挑战无限、开拓创新的大数据领域,书写辉煌篇章!

请在此深思:结合自己的认知和观察,谈谈大数据将会有如何未来的令人鼓舞的应用方向。期待各位能在下方评论区积极参与讨论,共同进步。同时,点赞及分享也不要忘哟,以便吸引更多同行加入我们的行列。