在数码领域的幕后,隐藏着一位平凡却不可忽视的关键角色——Batcher,它是数据处理环节中的中流砥柱。试想一下,我们的电脑与智能手机每时每刻都在传递大量的数据,这些信息纷至沓来,而Batcher正是那位于后台默默地收集、梳理并转向这些数据的工作者。尽管其工作性质似乎单一,然而实际操作中却面临诸多挑战,特别是在性能与效率间寻求最佳平衡点这一问题上。

Batcher的工作原理

巴彻算法的运行机制独特而富有吸引力。其角色如同尽职尽责的园丁,持续从花园中采集花朵(即数据),当花朵数量达到一定量后,便将之归纳整理为一束束,交予外部处理程序。在此流程中,巴彻算法于本地设立缓冲区域,形似临时花架,用以储存待打包花朵。

数据的积累与打包

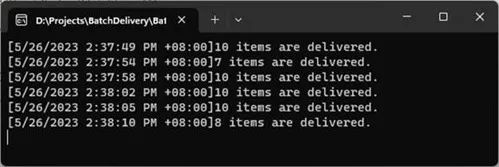

var batcher = new Batcher(

processor:Process,

batchSize:10,

interval: TimeSpan.FromSeconds(5));

var random = new Random();

while (true)

{

var count = random.Next(1, 4);

for (var i = 0; i < count; i++)

{

batcher.Add(Guid.NewGuid().ToString());

}

await Task.Delay(1000);

}

static void Process(Batch batch)

{

using (batch)

{

Console.WriteLine(

$"[{DateTimeOffset.Now}]{batch.Count} items are delivered.");

}

}

然而,详述而言,数据累积和压缩的关键环节为Batcher所担当。可将其视作一位杰出的商务人士,遵循经济规律行事,只选择在市场充足(数据充分)时才进行交易(数据压缩并发送)。采用此策略,能够降低交易频率,提升效率。在此过程中,Batcher设定两项触发条件以确保精准操作:数据量满足预定阈值及时间间隔超出特定时限。

ArrayPool的巧妙运用

为提升数据处理效率,Batcher巧妙运用ArrayPool这一共享工具箱。这犹如一块储存各类工具(数组)的大仓库,在需要时可自由取用并随时归还以备下一次使用。如此一来,不仅有效节约资源,且规避频繁内存分配,极大提升系统运行效能。

Batch类型的奥秘

原生类型’Batch’在数据处理中的角色至关重要,犹如精美礼品盒中蕴含诸多精选礼品(数据)。为保证这些礼品安全无虞地送到指定地点,该类型还精心设计了实现IDisposable接口,以便在处理完毕后,资源得到妥善回收与释放。

迭代器与Count属性的处理

在处理资料时,Batcher务必顾及资料的完整性,这便要求巧妙运用迭代器与Count特性的结合。犹如细致入微的园艺师,在花卉包装过程中严谨地查验每朵鲜花的状况,以确保呈献给花匠的花束至臻完善。

Container的内部机制

容器(Container)是Batcher内部的核心模块,专职于数据存储与管理任务。犹如一个系统精密的仓储中心,各类数据在此井然有序地安置其中。通过使用_index关键字,容器可以精确定位每一条新增或读取的数据,以保证整个操作流程的秩序性。

并发问题的解决

public sealed class Batch : IEnumerable, IDisposable where T : class

{

private bool _isDisposed;

private int? _count;

private readonly T[] _data;

private static readonly ArrayPool _pool

= ArrayPool.Create();

public int Count

{

get

{

if (_isDisposed)

throw new ObjectDisposedException(nameof(Batch));

if(_count.HasValue)

return _count.Value;

var count = 0;

for (int index = 0; index _data = data

?? throw new ArgumentNullException(nameof(data));

public void Dispose()

{

_pool.Return(_data, clearArray: true);

_isDisposed = true;

}

public IEnumerator GetEnumerator()

=> new Enumerator(this);

IEnumerator IEnumerable.GetEnumerator()

=> GetEnumerator();

public static T[] CreatePooledArray(int batchSize)

=> _pool.Rent(batchSize);

private void EnsureNotDisposed()

{

if (_isDisposed)

throw new ObjectDisposedException(nameof(Batch));

}

private sealed class Enumerator : IEnumerator

{

private readonly Batch _batch;

private readonly T[] _data;

private int _index = -1;

public Enumerator(Batch batch)

{

_batch = batch;

_data = batch._data;

}

public T Current

{

get

{

_batch.EnsureNotDisposed();

return _data[_index];

}

}

object IEnumerator.Current => Current;

public void Dispose() { }

public bool MoveNext()

{

_batch.EnsureNotDisposed();

return ++_index < _data.Length

&& _data[_index] is not null;

}

public void Reset()

{

_batch.EnsureNotDisposed();

_index = -1;

}

}

}

在处理过程中,Batcher也会遭遇并发问题。这犹如在繁荣市井,众多商家齐头并进进行交易,矛盾难以避免。为破此难题,他运用了InterLocked.Increase策略,保证了并发环境中的数据增量能规范实施。

自旋等待的巧妙运用

当数据数组已满时,Batcher运用自旋等待技术以提升运行效率。如同行车途中等待信号灯,驾驶员并不需停车关闭发动机,相反,他们让引擎持续转动,待到绿灯出现后立即起步,从而有效地节约了时间。

ReaderWriterLockSlim的巧妙运用

public sealed class Batcher where T : class

{

private readonly int _interval;

private readonly int _batchSize;

private readonly Action<Batch> _processor;

private volatile Container _container;

private readonly Timer _timer;

private readonly ReaderWriterLockSlim _lock = new();

public Batcher(

Action<Batch> processor,

int batchSize,

TimeSpan interval)

{

_interval = (int)interval.TotalMilliseconds;

_batchSize = batchSize;

_processor = processor;

_container = new Container(batchSize);

_timer = new Timer(_ => Process(), null, _interval, Timeout.Infinite);

}

private void Process()

{

if (_container.IsEmpty) return;

_lock.EnterWriteLock();

try

{

if (_container.IsEmpty) return;

var container = Interlocked.Exchange(

ref _container, new Container(_batchSize));

_ = Task.Run(() => _processor(container.AsBatch()));

_timer.Change(_interval, Timeout.Infinite);

}

finally

{

_lock.ExitWriteLock();

}

}

public void Add(T item)

{

_lock.EnterReadLock();

bool success = false;

try

{

success = _container.TryAdd(item);

}

finally

{

_lock.ExitReadLock();

}

if (!success)

{

Process();

new SpinWait().SpinOnce();

Add(item);

}

}

private sealed class Container

{

private volatile int _next = -1;

private readonly T[] _data;

public bool IsEmpty

=> _next == -1;

public Container(int batchSize)

=> _data = Batch.CreatePooledArray(batchSize);

public bool TryAdd(T item)

{

var index = Interlocked.Increment(ref _next);

if (index > _data.Length - 1) return false;

_data[index] = item;

return true;

}

public Batch AsBatch() => new(_data);

}

}

为消除棒法与加法运算间之冲突,Batcher采用了ReaderWriterLockSlim技术。此犹如热闹集市设置有序购销排位体系,确保各商家有序经营,防止混乱。

结语:Batcher的未来展望

尽管Batcher作为小角色并不引人注目,然其于数据处理领域却发挥举足轻重之效能。伴随着科技日新月异的变迁,我们期待着Batcher日益智能化且效率显著提升,从而为我们的数字化生活提供更优质便捷及前所未有的体验。

文末备注:尊敬的读者阁下,您是否同样为之倾心于BATcher构造的神奇世界?对于其未来走向,您又作何展望?请在评论区畅所欲言,与我们共同关注BATcher的发展前景,为数字领域的和谐繁荣贡献绵薄之力。