人工智能作为前沿科技,已然深度渗透到生活之中,成为人们决策的重要影响因素。然而,在这个数字化的时代,公平和责任是否得到了充分体现呢?今天,让我们共同探讨这一问题,以期找到科技便利性与社会公正之间的平衡点。

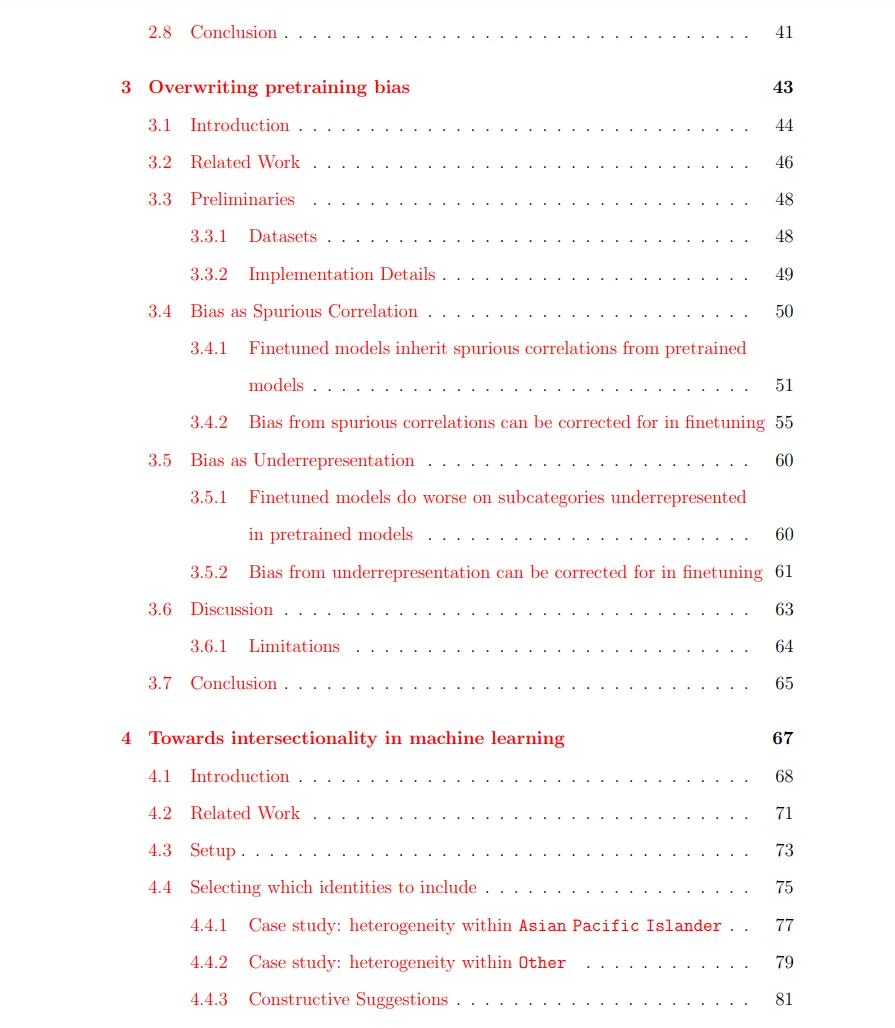

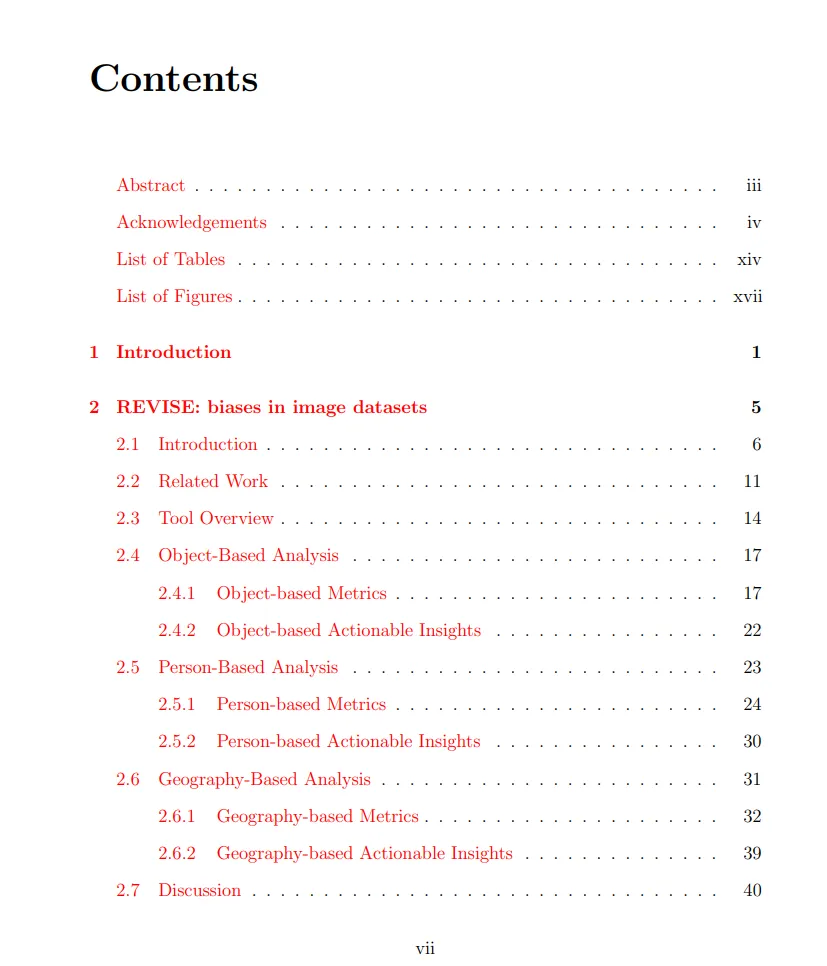

来源:专知 本文约3000字,建议阅读5分钟 在本论文中,我们将描述贯穿整个机器学习流程的研究,这些研究桥接了这些方法,并利用社会影响来指导技术工作。

一、机器学习的两面性

机器学习,运用人工智能模拟人类认知与能力提升,既有显著效益,也潜藏潜在风险。一则能有效应对大容量数据时代的问题,做出精准判断;然而,若操作失误,反而会强化偏颇和不公正。因此在技术的规划及执行阶段,对公正性和责任心应予以高度关注。

追求技艺精进之际,务必慎重考量技术所产生的社会影响。例如,由于设计偏差,机器学习体系有可能无意间加剧社会不公现象。以招聘系统为例,若受历史数据性别偏见影响,可能导致其更倾向于某个性别候选人。在此情况下,技术的高效性反而成为了公正性的障碍。

二、数学公平与社会公平的鸿沟

在机器学习领域,公平常被视为等同于数学里的平等,确保每个参与者都能平等地与算法交往。然而,这种数学概念的公平是否真正体现了社会多元性和复杂性的本质?实际中,很多时候,看似精确的公平定义并未能充分挖掘社会现实中那些精细且深入的公正观点。

公平社会不仅仅是个数值概念,亦意指尊重和兼顾不同背景及需求人群的现实情况。例如,如果某个以服务社区为核心的机器学习项目只关注整体数据,却忽视了特定群体的独特需求,那么这个项目很有可能因为缺乏针对性而无法真正满足所有人的期望。

三、社会背景的力量

为了赋予机器学习责任意识,只依靠科技是不充分的。明智地考虑社会背景,这是实现公平机器学习的核心要素。因此,在建立每一个机器学习模型时,务必深刻理解其所处的社会环境,并对潜在的社会影响进行全面评估。

深入了解社会环境,我们能更好地把握各阶层的需求与期望,从而构建更贴合实际且公平的机器学习模型。这种深度参与不仅提高了科技对社会的贡献,还促进了公众对科技的接受和理解。

四、数据集的偏见问题

作为机器学习模型的基石,数据集的优质至关重要,由其直接影响着模型的公平性和准确度。然而,一些源于历史或社会背景的隐藏偏见可能无处不在,并可能在模型训练中被无意放大,导致模型产生偏颇结果。

有效防范数据集引发的偏见问题需从源头上进行控制。首先,在数据收集阶段,必须避免偏见感染;接着,借助高效的特殊技术,有针对性地在前期处理及训练阶段发现并纠正各类偏差。只有贯彻以上措施,才能保证机器学习模型输出成果的准确无误。

五、模型评估的全面性

在机器学习流程中,模型测评处于关键环节。它不仅是评价模型性能重要手段,更是保证模型能够实现公正和负责任使命的保障。然而,传统的模型测评往往只关注性能指标,而忽视了模型可能带来的社会影响。

创建更公平合理的AI系统需建立完善的评价标准,需要纳入模型精度衡量以及社会效果预估等方面。如此不仅保障了开发的AI模型在科技领域居于高端,同时也能对社会带来积极贡献。

六、技术与社会的对话

卓越的责任驱动型人工智能技术研发及实践不仅是单向的技术挑战,更涉及复杂的社会问题解决策略。为此,在研发和应用过程中,我们必须积极参与并持续与社会进行深度对话,以深入理解他们的需求和期望。

此项研究与社会的紧密互动期间,能帮助我们更好且精确地研制机器学习体系结构,进而充分探索和解决可能衍生出的潜在社会问题。借助此种方法,我们能够确保科技发展始终朝着正确的方向稳步前行。

七、未来的展望

满怀期待地推进AI(人工智能)发展,持续提升技术与社会观念水平,必将构建出公正负责任的AI系统。然而,这一愿景的实现离不开当下的不懈努力。

齐心协力推动机器学习助力文明进步,避免其被滥用于社会不公正。让我们的科技成果在虚实之间闪耀光芒。